英偉達發(fā)布 80 億參數(shù)新AI模型:精度、效率高,可在 RTX 作站上部署

2024-08-23 08:22:27 IT之家8 月 23 日消息,英偉達于 8 月 21 日發(fā)布博文,發(fā)布了 Mistral-NeMo-Minitron 8B 小語言 AI 模型,具備精度高、計算效率高等優(yōu)點,可在 GPU 加速的數(shù)據(jù)中心、云和工作站上運行模型。

英偉達攜手 Mistral AI 上月發(fā)布開源 Mistral NeMo 12B 模型,在此基礎(chǔ)上英偉達再次推出更小的 Mistral-NeMo-Minitron 8B 模型,共 80 億個參數(shù),可以在搭載英偉達 RTX 顯卡的工作站上運行。英偉達表示通過寬度剪枝(width-pruning)Mistral NeMo 12B,并知識蒸餾(knowledge distillation)輕度重新訓(xùn)練后獲得 Mistral-NeMo-Minitron 8B,相關(guān)成果發(fā)表在《Compact Language Models via Pruning and Knowledge Distillation》論文中。

剪枝通過去除對準(zhǔn)確率貢獻最小的模型權(quán)重來縮小神經(jīng)網(wǎng)絡(luò)。在 "蒸餾" 過程中,研究小組在一個小型數(shù)據(jù)集上重新訓(xùn)練剪枝后的模型,以顯著提高通過剪枝過程而降低的準(zhǔn)確率。

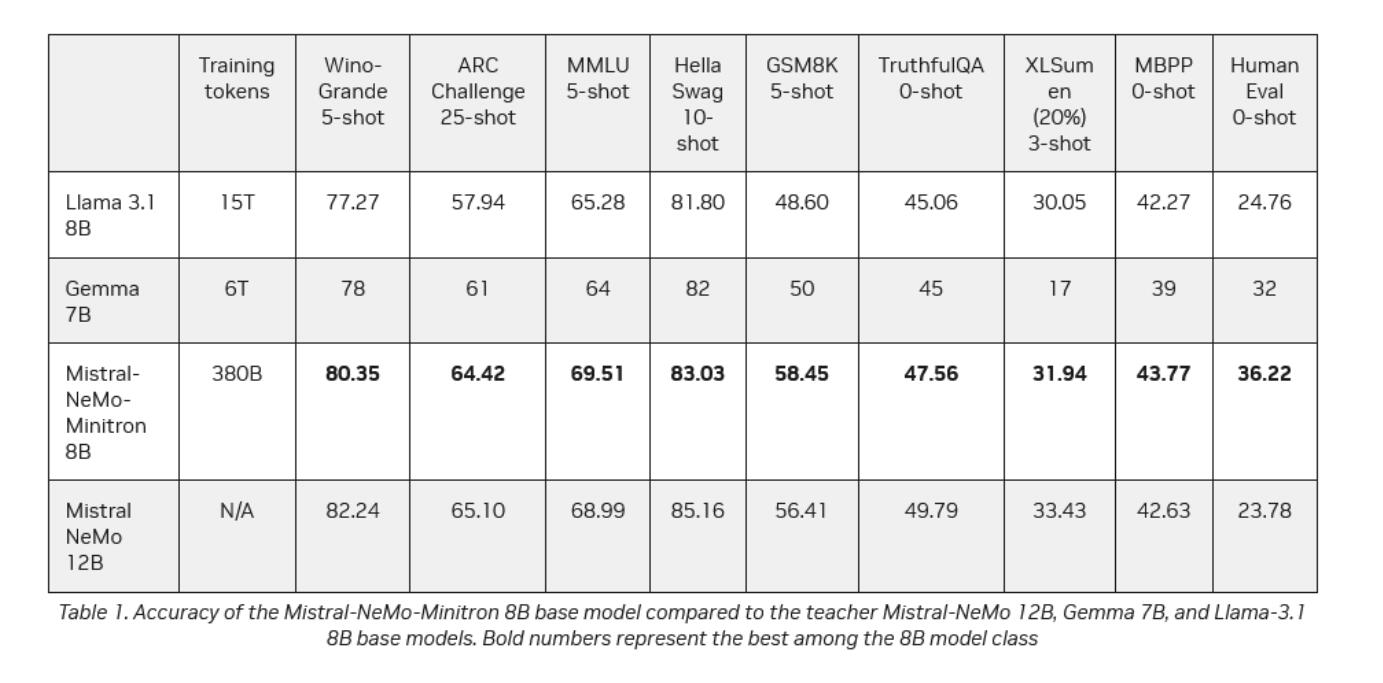

就其規(guī)模而言,Mistral-NeMo-Minitron 8B 在語言模型的九項流行基準(zhǔn)測試中遙遙領(lǐng)先。這些基準(zhǔn)涵蓋了各種任務(wù),包括語言理解、常識推理、數(shù)學(xué)推理、總結(jié)、編碼和生成真實答案的能力。IT之家附上相關(guān)測試結(jié)果如下:

免責(zé)聲明:本文由作者原創(chuàng)。文章內(nèi)容系作者個人觀點,轉(zhuǎn)載目的在于傳遞更多信息,并不代表EETOP贊同其觀點和對其真實性負責(zé)。如涉及作品內(nèi)容、版權(quán)和其它問題,請及時聯(lián)系我們,我們將在第一時間刪除。

EETOP 官方微信

創(chuàng)芯大講堂 在線教育

半導(dǎo)體創(chuàng)芯網(wǎng) 快訊

相關(guān)文章