英偉達(dá)的STEAL AI讓神經(jīng)網(wǎng)絡(luò)擁有更好的計(jì)算機(jī)視覺(jué)

2019-06-19 11:00:28 新浪VR

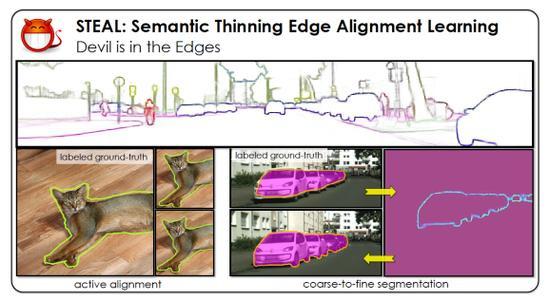

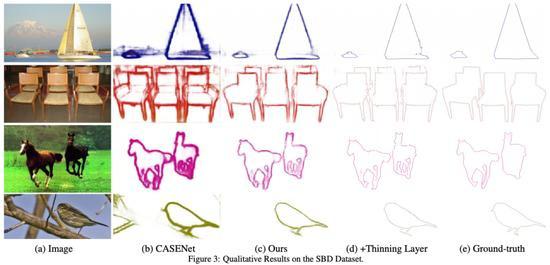

在研究人員的實(shí)驗(yàn)中,語(yǔ)義細(xì)化的邊緣對(duì)齊學(xué)習(xí)(steal)能夠?qū)⒆钕冗M(jìn)的casenet語(yǔ)義邊界預(yù)測(cè)模型的精度提高4%。更精確地識(shí)別物體的邊界可以應(yīng)用于計(jì)算機(jī)視覺(jué)任務(wù),從圖像生成到三維重建到物體檢測(cè)。

STEAL可用于改進(jìn)現(xiàn)有的CNNs或邊界檢測(cè)模型,但研究人員還認(rèn)為它可以幫助他們更有效地標(biāo)記或注釋計(jì)算機(jī)視覺(jué)模型的數(shù)據(jù)。為證明這一點(diǎn),STEAL方法用于改進(jìn)城市景觀,這是2016年首次在計(jì)算機(jī)視覺(jué)和模式識(shí)別(CVPR)會(huì)議上引入的城市環(huán)境數(shù)據(jù)集。

在GitHub上,STEAL框架以像素為單位學(xué)習(xí)和預(yù)測(cè)對(duì)象邊緣,研究人員稱之為“主動(dòng)對(duì)齊”。“在訓(xùn)練過(guò)程中對(duì)注釋噪聲進(jìn)行明確的推理,以及為網(wǎng)絡(luò)提供一個(gè)從端到端排列不當(dāng)?shù)臉?biāo)簽中學(xué)習(xí)的分級(jí)公式,也有助于產(chǎn)生結(jié)果。”

據(jù)arXiv報(bào)道,研究者在4月發(fā)表的一篇論文中說(shuō):“我們進(jìn)一步表明,我們預(yù)測(cè)的邊界比最新的DeepLab-v3分割輸出得到的邊界明顯更好,同時(shí)使用了更輕量級(jí)的架構(gòu)。”并在6月9日進(jìn)行了修訂。

“魔鬼就在邊緣:從嘈雜的注釋中學(xué)習(xí)語(yǔ)義邊界”將在本周于加州長(zhǎng)灘舉行的CVPR 2019年會(huì)議上分享。英偉達(dá)在今天的一篇博客文章中說(shuō),近12篇部分由英偉達(dá)研究公司撰寫(xiě)的研究論文將在會(huì)議上以口頭陳述的形式分享。

免責(zé)聲明:本文由作者原創(chuàng)。文章內(nèi)容系作者個(gè)人觀點(diǎn),轉(zhuǎn)載目的在于傳遞更多信息,并不代表EETOP贊同其觀點(diǎn)和對(duì)其真實(shí)性負(fù)責(zé)。如涉及作品內(nèi)容、版權(quán)和其它問(wèn)題,請(qǐng)及時(shí)聯(lián)系我們,我們將在第一時(shí)間刪除!

EETOP 官方微信

創(chuàng)芯大講堂 在線教育

半導(dǎo)體創(chuàng)芯網(wǎng) 快訊

相關(guān)文章