DeepSeek 團隊神操作:用“匯編”取代CUDA 讓性能狂飆

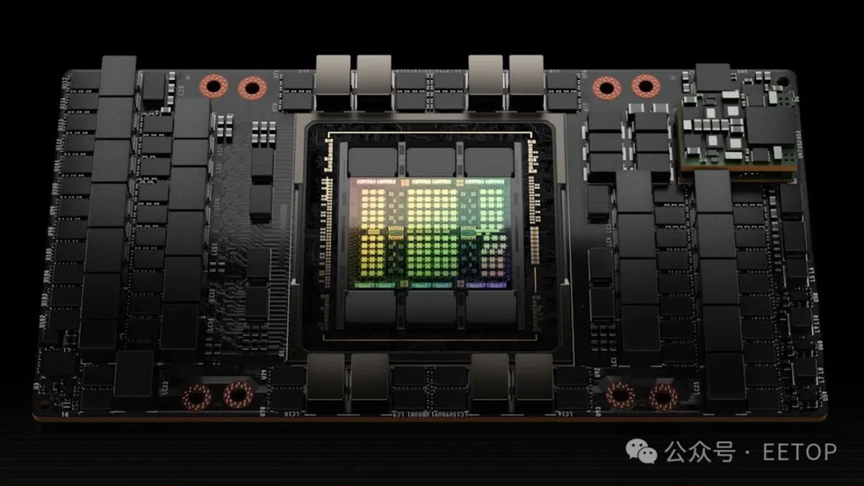

2025-01-29 10:01:27 EETOP在人工智能領域,DeepSeek 引發了巨大轟動。它借助由 2048 塊英偉達 H800 GPU 組成的集群,僅用約兩個月時間就完成了擁有 6710 億參數的混合專家(MoE)語言模型訓練,效率比 Meta 等人工智能行業領軍企業高出 10 倍。據 @Jukanlosreve 援引韓國未來資產證券(Mirae Asset Securities Korea)的分析,這一突破得益于大量細粒度的優化措施,以及采用了類似匯編語言的英偉達并行線程執行(PTX)編程,而非英偉達的 CUDA 編程。

英偉達的并行線程執行(PTX)是英偉達公司專為其圖形處理器(GPU)設計的一種中間指令集架構。PTX 處于高級 GPU 編程語言(如 CUDA C/C++ 或其他語言前端)與低級機器代碼(流式匯編,即 SASS)之間。PTX 是一種接近硬件底層的指令集架構,它將 GPU 視為數據并行計算設備,因而能夠實現細粒度的優化操作,例如寄存器分配以及線程 / 線程束級別的調整,而這些功能是 CUDA C/C++ 等其他編程語言所無法實現的。一旦將 PTX 轉換為 SASS,便會針對特定一代的英偉達 GPU 進行優化處理。

例如,在訓練其 V3 模型時,DeepSeek 對英偉達 H800 GPU 進行了重新配置:在 132 個流式多處理器中,專門分配了 20 個用于服務器間的通信任務,此舉可能是為了對數據進行壓縮和解壓縮處理,以克服處理器的連接限制,進而加快數據傳輸速度。為了最大限度地提升性能,DeepSeek 還采用了先進的流水線算法,可能還進行了更為精細的線程 / 線程束級別的調整操作。

這些改進措施遠遠超出了標準的 CUDA 級開發范疇,然而,其維護難度極高已是業內公認的事實。因此,這種程度的優化成果充分體現了 DeepSeek 工程師團隊卓越的技術水平。受美國相關限制措施的影響,全球 GPU 短缺問題進一步加劇,這迫使像 DeepSeek 這樣的企業不得不采取創新解決方案,而 DeepSeek 也成功實現了技術突破。然而,目前尚無法明確 DeepSeek 為取得這些成果在研發過程中投入的資金數額。

這一突破性進展對市場造成了一定的沖擊,部分投資者認為,新的人工智能模型對高性能硬件的需求將會降低,這對英偉達等公司的產品銷售產生了不利影響。行業資深人士,如英特爾前首席執行官帕特?基辛格則認為,人工智能等應用領域能夠充分利用其所能獲取的全部計算能力。對于 DeepSeek 的這一突破,基辛格認為這為在大眾市場中的大量廉價設備中集成人工智能技術提供了可行途徑。OpenAI 首席執行官山姆?阿爾特曼也對 DeepSeek 給予了 “令人印象深刻” 的評價。然而在 2023 年,他曾表示與 DeepSeek 展開競爭幾乎是不可能之事。

關鍵詞: DeepSeek