數(shù)據(jù)中心中的AI推理:打破效率與成本的權(quán)衡

2025-02-13 12:38:49 EETOP訓(xùn)練和推理包括數(shù)據(jù)中心 AI 處理的兩個(gè)關(guān)鍵方面。了解兩者之間的區(qū)別,以及所涉及的成本效益問題。

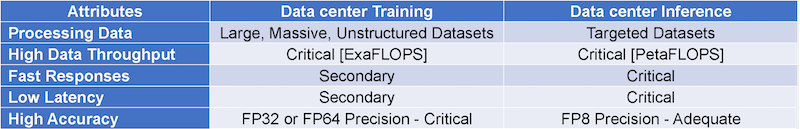

在數(shù)據(jù)中心執(zhí)行人工智能 (AI) 工作負(fù)載(圖 1)涉及兩個(gè)關(guān)鍵過程:訓(xùn)練和推理。乍一看,這些過程似乎很相似 — 都涉及讀取數(shù)據(jù)、處理數(shù)據(jù)和生成輸出。仔細(xì)檢查會(huì)發(fā)現(xiàn)它們之間存在顯著差異。

以具有數(shù)千億甚至數(shù)萬億個(gè)參數(shù)的大型語言模型 (LLM) 為例,AI 模型的復(fù)雜性呈爆炸式增長,這推動(dòng)了對(duì)訓(xùn)練和推理的前所未有的計(jì)算需求。然而,它們的運(yùn)營要求和優(yōu)先事項(xiàng)卻大相徑庭。

訓(xùn)練是一個(gè)計(jì)算量非常大的過程,需要 ExaFLOPS 的能力來分析和提取大量(通常是非結(jié)構(gòu)化數(shù)據(jù)集)中的模式。此過程可能持續(xù)數(shù)周甚至數(shù)月,因?yàn)槟P蜁?huì)進(jìn)行迭代優(yōu)化以實(shí)現(xiàn)高精度。

推理雖然對(duì)計(jì)算要求也很高,但通常在較小的規(guī)模上運(yùn)行,通常以 PetaFLOPS 為單位。它的關(guān)注點(diǎn)更窄,將經(jīng)過訓(xùn)練的模型應(yīng)用于特定任務(wù),例如響應(yīng)用戶查詢,使其更具針對(duì)性和簡化性。

對(duì)于訓(xùn)練,準(zhǔn)確性優(yōu)先于速度。該過程涉及長時(shí)間運(yùn)行,模型持續(xù)運(yùn)行以微調(diào)輸出并減少幻覺的可能性。

另一方面,推理優(yōu)先考慮速度。它必須幾乎即時(shí)提供結(jié)果以滿足用戶期望,響應(yīng)時(shí)間通常以毫秒到幾秒鐘為單位。

延遲是訓(xùn)練期間的次要問題,因?yàn)橹攸c(diǎn)是獲得精確可靠的結(jié)果,而不是立竿見影的結(jié)果。

相反,推理依賴于低延遲來保持流暢的用戶體驗(yàn)。高延遲響應(yīng)可能會(huì)中斷交互,使延遲成為性能的關(guān)鍵指標(biāo)。

訓(xùn)練需要高精度,通常使用 fp32 或 fp64 等格式,以確保模型可靠并最大限度地減少錯(cuò)誤。這種高精度水平需要強(qiáng)大的處理能力和連續(xù)運(yùn)行。

Inference 通過為許多應(yīng)用程序采用 fp8 等較低精度的格式來平衡準(zhǔn)確性與效率。

這些格式顯著降低了計(jì)算需求,而不會(huì)影響有效結(jié)果所需的質(zhì)量。

表 1 說明了五個(gè)關(guān)鍵屬性的這些區(qū)別,強(qiáng)調(diào)了訓(xùn)練和推理如何優(yōu)化性能、精度和效率,以滿足 AI 工作負(fù)載的獨(dú)特要求。

數(shù)據(jù)中心的巨大計(jì)算需求需要將一排排專用硬件安裝在堅(jiān)固的重型機(jī)柜中,這些機(jī)柜旨在容納大型高性能系統(tǒng)。這些裝置會(huì)大規(guī)模消耗能源,通常以吉瓦為單位,這會(huì)產(chǎn)生大量熱量,并且需要大量的冷卻系統(tǒng)以及定期的專門維護(hù),以確保最佳運(yùn)行。

為 AI 處理量身定制的數(shù)據(jù)中心成本非常高。這些費(fèi)用源于多種因素:購買尖端硬件、對(duì)設(shè)施建設(shè)的大量投資、由技術(shù)人員進(jìn)行的定期維護(hù)以及全年 24/7 運(yùn)行所需的無情能源消耗。

在訓(xùn)練中,重點(diǎn)仍然是生成準(zhǔn)確的模型,通常忽略了成本考慮。普遍的心態(tài)是“不惜一切代價(jià)完成工作”。

相比之下,推理對(duì)成本高度敏感。每次查詢的成本成為一個(gè)重要的指標(biāo),特別是對(duì)于每天管理數(shù)百萬甚至數(shù)十億個(gè)查詢的應(yīng)用程序。麥肯錫 2022 年的一項(xiàng)分析說明了高吞吐量 AI 系統(tǒng)的制約因素。例如,Google 搜索每秒處理大約 100000 個(gè)查詢,為了保持經(jīng)濟(jì)可行性,每個(gè)查詢的目標(biāo)成本約為 0.002 USD。相比之下,ChatGPT-3 的每次查詢成本,雖然由于通用和專業(yè)用例的差異而無法直接比較,但估計(jì)每次查詢約為 0.03 美元,凸顯了達(dá)到 Google 級(jí)別查詢經(jīng)濟(jì)性所需的效率差距。

電源效率是一個(gè)關(guān)鍵的平衡行為。雖然推理通常比訓(xùn)練消耗更少的功率,但提高推理的能源效率可以顯著降低成本并減少對(duì)環(huán)境的影響。此領(lǐng)域的增強(qiáng)功能使數(shù)據(jù)中心能夠在現(xiàn)有能源限制內(nèi)提供更強(qiáng)大的計(jì)算能力,或者通過減少冷卻和基礎(chǔ)設(shè)施要求來降低每個(gè)計(jì)算單元的成本。

這種形勢(shì)凸顯了對(duì)創(chuàng)新解決方案的迫切需求,這些解決方案必須超越傳統(tǒng)的計(jì)算效率和成本之間的權(quán)衡。通過應(yīng)對(duì)這些挑戰(zhàn),數(shù)據(jù)中心的下一代 AI 進(jìn)步可以在性能、可擴(kuò)展性和可持續(xù)性方面實(shí)現(xiàn)突破。

當(dāng)前的數(shù)據(jù)中心 AI 加速器主要由圖形處理單元 (GPU) 提供支持,用于訓(xùn)練和推理。雖然單個(gè) GPU 設(shè)備可以提供 PetaFLOPS 規(guī)模的性能,但其設(shè)計(jì)架構(gòu)(最初針對(duì)圖形加速進(jìn)行了優(yōu)化)難以滿足推理所需的延遲、功耗和成本效率的嚴(yán)格要求。

GPU 在訓(xùn)練和推理中的可互換使用是問題的核心。盡管 GPU 具有計(jì)算能力,但無法達(dá)到經(jīng)濟(jì)可擴(kuò)展的 AI 解決方案所需的每次查詢成本基準(zhǔn)。

GPU 可以提高數(shù)據(jù)處理性能,但不會(huì)提高數(shù)據(jù)移動(dòng)吞吐量。差距源于基本的物理和技術(shù)限制:

導(dǎo)體中的能量耗散:當(dāng)電力流過導(dǎo)體時(shí),能量耗散是不可避免的。較長的導(dǎo)體會(huì)導(dǎo)致更大的能量損失,從而加劇效率低下。

Memory versus Logic Power Dissipation:該規(guī)則的推論假設(shè) memory作耗散的能量可以達(dá)到用于處理數(shù)據(jù)的 logic 消耗的能量的 1,000 倍。這種差異被簡潔地描述為內(nèi)存墻,它突出了內(nèi)存和數(shù)據(jù)訪問策略創(chuàng)新以優(yōu)化電源效率的必要性。

內(nèi)存墻是指處理器性能和內(nèi)存帶寬之間越來越大的差距,這一差距在過去 30 年中顯著擴(kuò)大。這種不平衡會(huì)降低處理器效率,增加功耗并限制可擴(kuò)展性。

一種常用的解決方案,隨著時(shí)間的推移而改進(jìn),包括通過引入多級(jí)分層緩存來緩沖處理器附近的內(nèi)存通道。通過緩存經(jīng)常訪問的數(shù)據(jù),數(shù)據(jù)路徑顯著縮短,從而提高性能。

沿著內(nèi)存層次結(jié)構(gòu)向下移動(dòng),存儲(chǔ)結(jié)構(gòu)從單個(gè)位可尋址寄存器過渡到緊密耦合的內(nèi)存 (TCM)、暫存器內(nèi)存和高速緩存。雖然這種進(jìn)展會(huì)增加存儲(chǔ)容量,但也會(huì)降低執(zhí)行速度,因?yàn)樾枰嗟闹芷趤韺?shù)據(jù)移入和移出內(nèi)存。

內(nèi)存層次結(jié)構(gòu)越深,對(duì)延遲的影響就越大,最終會(huì)降低處理器效率。

人工智能的內(nèi)在潛力,特別是生成式人工智能,尤其是代理人工智能,受到記憶帶寬有限度的嚴(yán)重阻礙。雖然 GPU 是數(shù)據(jù)中心 AI 訓(xùn)練的首選,但它們的效率因算法而異。例如,據(jù)報(bào)道,GPT-4 MoE(專家混合)的效率下降到僅 3-5%,但在 Llama3-7B 上可以達(dá)到 30% 左右。

在理想情況下,用 registers 替換 TCM、scratchpad memory 和 cache 將徹底改變性能。這種方法會(huì)將 hierarchical memory structure 轉(zhuǎn)換為單個(gè)大型高帶寬 memory,可在一個(gè) clock cycle中直接訪問。

這樣的架構(gòu)將提供高執(zhí)行速度、低延遲和低功耗,同時(shí)最大限度地減少硅面積。至關(guān)重要的是,在處理過程中將新數(shù)據(jù)從外部存儲(chǔ)器加載到 registers 不會(huì)中斷系統(tǒng)吞吐量。

這種先進(jìn)的設(shè)計(jì)有可能顯著提高處理器效率,特別是對(duì)于處理資源密集型任務(wù)。當(dāng)前的 GPU 可能難以跟上,在處理超過 1 萬億個(gè)參數(shù)的 LLM 時(shí)可能會(huì)耗盡容量。然而,這種創(chuàng)新的內(nèi)存架構(gòu)確保了對(duì)類似高需求工作負(fù)載的無縫處理,提供卓越的性能,而不會(huì)出現(xiàn)阻礙傳統(tǒng) GPU 設(shè)置的瓶頸。這一突破可能會(huì)重新定義復(fù)雜計(jì)算的處理方式,為 AI 及其他領(lǐng)域帶來新的可能性。

為了確保可擴(kuò)展的 AI 解決方案,必須在原始計(jì)算能力和成本考慮之間取得平衡。到 2028 年,LLM 推理將主導(dǎo)數(shù)據(jù)中心工作負(fù)載的預(yù)測(cè)強(qiáng)調(diào)了這一挑戰(zhàn)。穆迪和貝萊德的分析師預(yù)測(cè),生成式 AI 和自然語言處理的快速增長將推動(dòng)數(shù)據(jù)中心基礎(chǔ)設(shè)施的大幅升級(jí)。

這種增長需要制定策略來減少對(duì)昂貴加速器的依賴,同時(shí)提高性能。專用集成電路 (ASIC) 和張量處理單元 (TPU) 等新興技術(shù)提供了一條充滿希望的前進(jìn)道路。這些專用架構(gòu)旨在優(yōu)化推理工作負(fù)載,優(yōu)先考慮延遲、功耗和成本方面的效率。

滿足 AI 推理的獨(dú)特需求需要硬件和系統(tǒng)設(shè)計(jì)的范式轉(zhuǎn)變。通過集成創(chuàng)新架構(gòu)和重新構(gòu)想支持軟件生態(tài)系統(tǒng),數(shù)據(jù)中心可以克服計(jì)算效率和經(jīng)濟(jì)可行性之間的傳統(tǒng)權(quán)衡。

隨著推理工作負(fù)載越來越多地塑造 AI 的未來,克服延遲和功耗方面的挑戰(zhàn)至關(guān)重要。通過專注于經(jīng)濟(jì)高效和高性能的解決方案,該行業(yè)可以確保 AI 技術(shù)的可持續(xù)部署。這將為未來鋪平道路,讓 AI 驅(qū)動(dòng)的洞察在全球范圍內(nèi)都能獲得且負(fù)擔(dān)得起,從而實(shí)現(xiàn)變革性的實(shí)際應(yīng)用。

EETOP 官方微信

創(chuàng)芯大講堂 在線教育

半導(dǎo)體創(chuàng)芯網(wǎng) 快訊

相關(guān)文章