特斯拉的一張芯片圖片引發猜想:臺積電InFO_SoW的首次實現?

2021-08-10 13:29:39 EETOP

考慮到特斯拉剛剛建造了可能被一些人認為是世界第三大的超級計算機,這個時機相當有趣。那是用Nvidia的GPU和Super Micro Systems建造的。

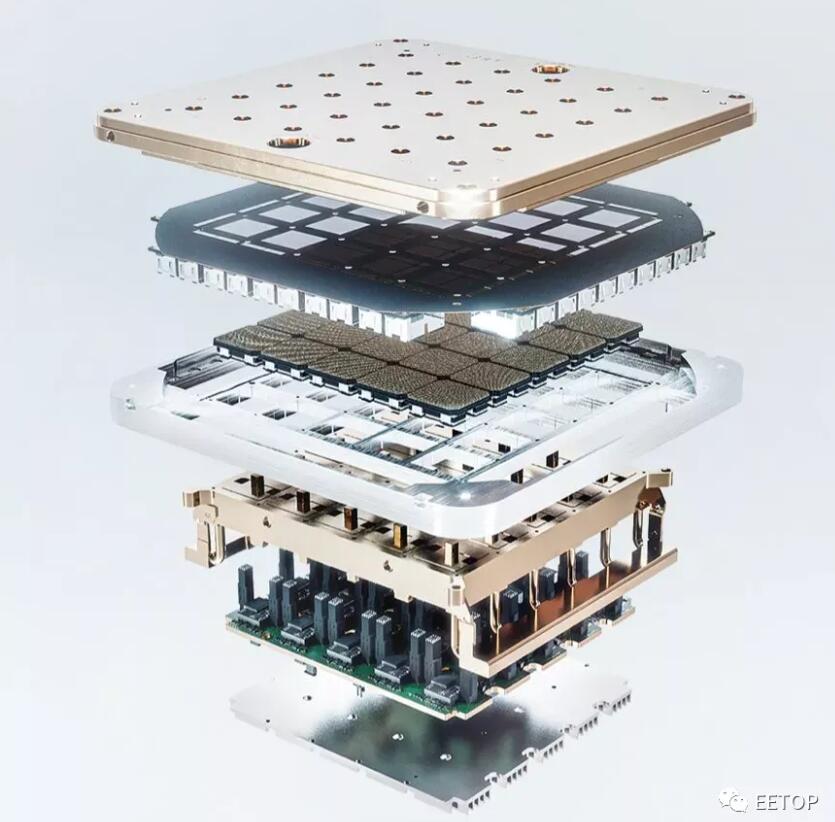

乍一看,它看起來有一個載體、散熱片和電源傳輸。當然,最有趣的部分是芯片。它有一個大的BGA焊盤陣列和一個5×5的芯片陣列。這種類型的封裝看起來令人難以置信的非正統,我們唯一能想到的是臺積電的晶圓上集成扇出系統技術InFO_SoW (System-on-Wafer)。以下是該論文在IEEE上的鏈接。

https://ieeexplore.ieee.org/document/9159219

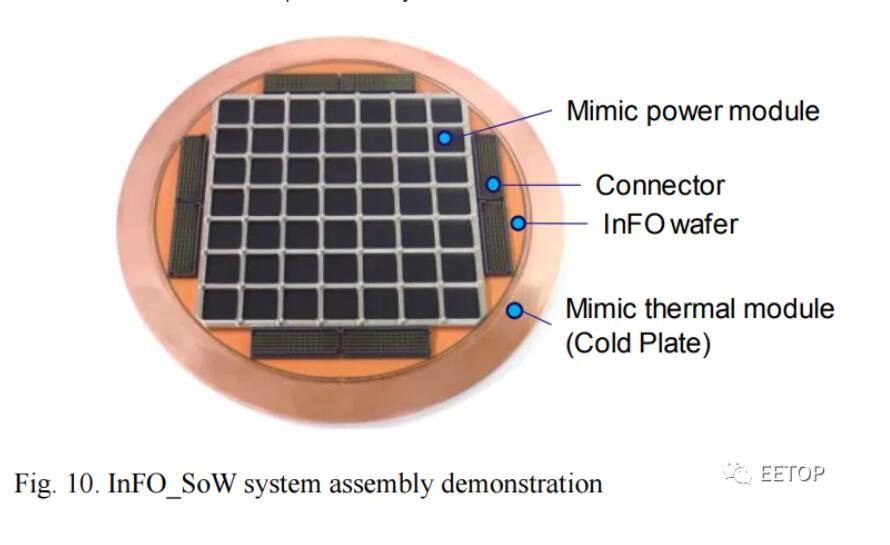

這張圖片看起來與特斯拉的芯片非常相似,并提供了一些見解。就像特斯拉的圖片一樣,有一個冷板。各種芯片排列成一個網格,一個InFo Wafer,還有連接器。這些結構看起來是1比1的匹配,但它們的確切細節看起來與最初的臺積電研究略有不同。

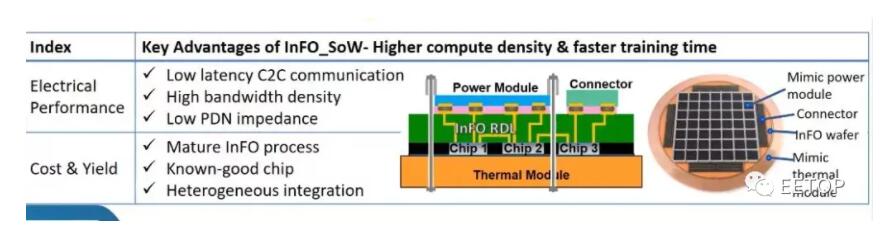

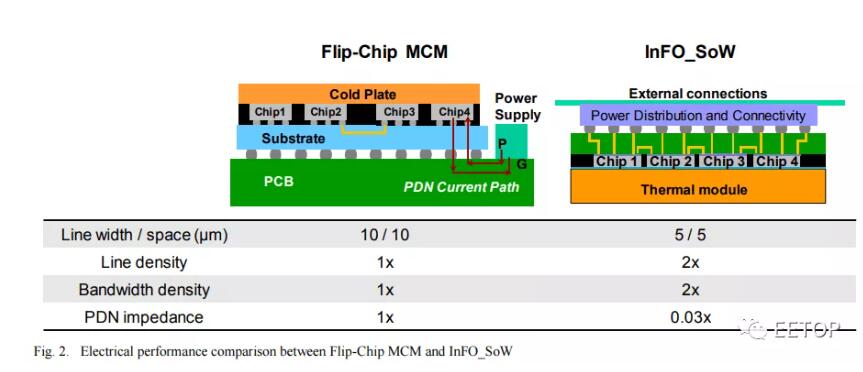

InFO_SoW通過作為載體本身,消除了對襯底和PCB的使用。在一個緊湊的系統內緊密包裝的多個芯片陣列使該解決方案能夠獲得晶圓級優勢,如低延遲的芯片間通信、高帶寬密度和低PDN阻抗,以獲得更大的計算性能和電源效率。除了異構芯片集成外,其wafer-field處理能力還支持基于小芯片的設計,以實現更大的成本節約和設計靈活性。

這突破了目前多芯片模塊的障礙。對于基于插板的技術,如Nvidia數據中心GPU,它們受到插板制造極限的限制。臺積電的第5 代 CoWoS-S 最近 ,這種方法涉及到一些制造困難,因為插板本身就是一個硅芯片。這種類型的封裝在為巨大的人工智能工作負載擴展芯片數量方面具有局限性。

另一種方法是倒裝芯片封裝。最著名的采用這種封裝的 MCM 設計是 AMD CPU。它們不存在reticle的限制問題,但在功率和線密度方面存在巨大缺陷。在芯片間數據傳輸上會消耗更多的電量,并且芯片之間的帶寬是有限的。由于這些限制,這種類型的封裝并不太適合規模巨大的 AI 工作負載。

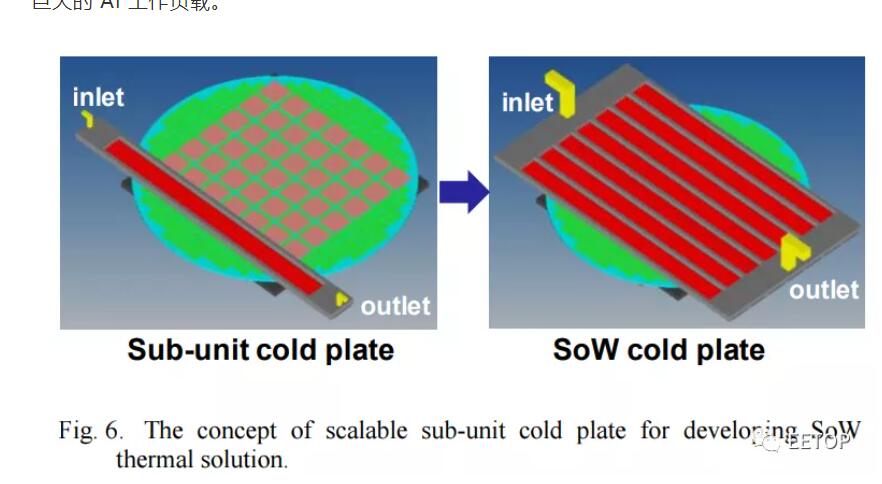

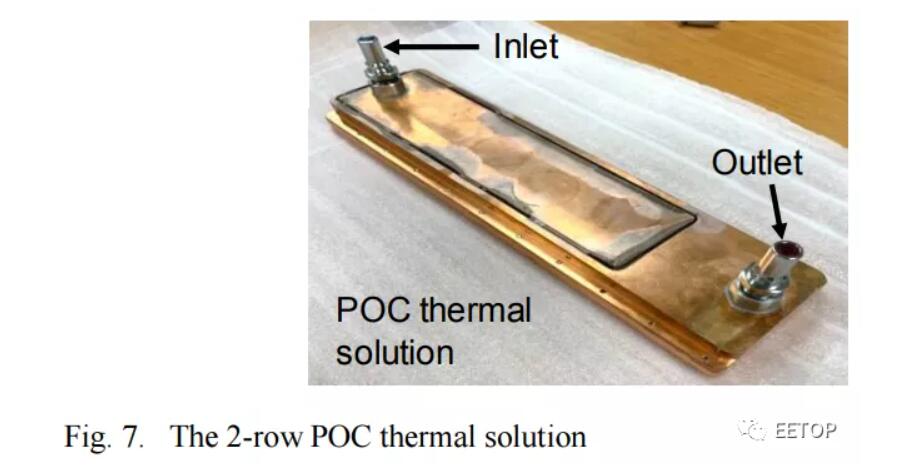

隨著特斯拉希望在其 Dojo 超級計算機設計中實現的擴展,將會產生大量的熱量。InFO_SoW能夠提供 7,000W 的功率。相比之下,Nvidia 的數據中心 A100 GPU 的配置為 500W。這需要大量考慮冷卻問題,而臺積電關于InFO_SoW 上的論文提供了解決方案。

這張圖片相當粗糙,但特斯拉圖片中的冷卻板看起來很相似,因為它有很多入口和出口。水冷是這種功率和熱密度水平的必要條件。

另一個引人注目的元素是似乎沒有任何 HBM 或其他基于 DRAM 的技術。 與 Cerebras 非常相似,它們很可能采用完全依賴于芯片 SRAM 的設計。

雖然我們很高興看到8月19日的特斯拉人工智能日會發生什么,但我們不會對這一芯片的具體細節過于激動。InFO_SoW只是一種猜測,盡管之前有一些傳言稱特斯拉、博通和臺積電將合作將其產品化。谷歌與博通在其人工智能加速器的TPU系列上有類似的安排。晶圓上的系統技術(system on wafer)與集成扇出的結合可以實現驚人的人工智能性能,這是目前 Nvidia 和其他公司的 AI 加速器夢寐以求的。

此外幾乎可以肯定的是,三星生產的下一個芯片將應用在他們的5納米節點上。這看起來可能是一個完全不同的芯片,芯片面積更大、封裝方式非常不同。上面的圖片將無法進入大規模生產的汽車,而是在數據中心訓練巨大的人工智能網絡,然后用于汽車的自動駕駛。