一個故意不通過圖靈測試的人工智能-2

2016-03-13 17:24:56 n第二部分開始:

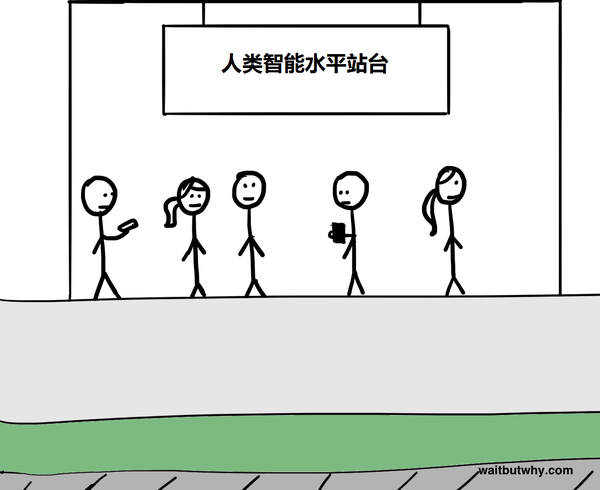

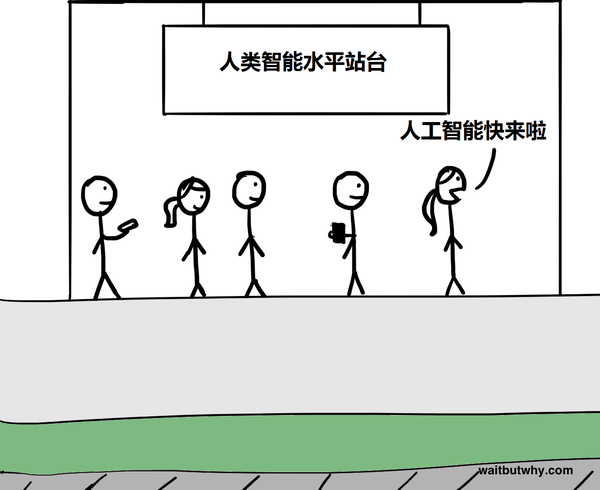

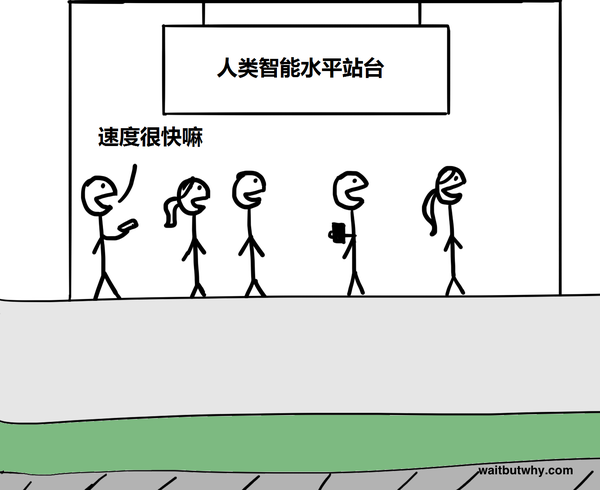

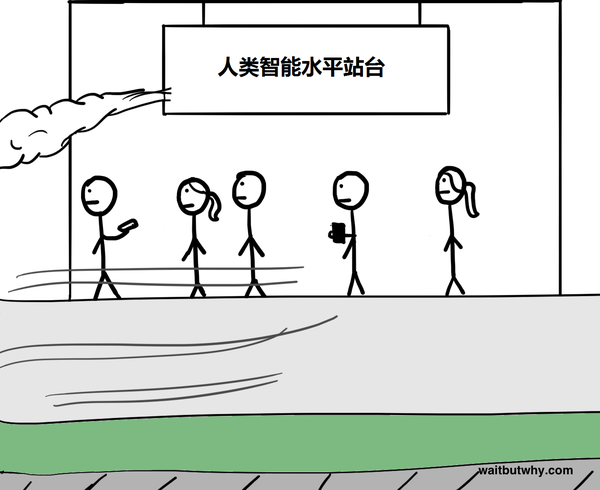

文章的第一部分討論了已經在我們日常生活中隨處可見的弱人工智能,然后討論了為什么從弱人工智能到強人工智能是個很大的挑戰,然后我們談到了為什么技術進 步的指數級增長表面強人工智能可能并不那么遙遠。第一部分的結束,我們談到了一旦機器達到了人類級別的智能,我們將見到如下的場景:

這讓我們無所適從,尤其考慮到超人工智能可能會發生在我們有生之年,我們都不知道該用什么表情來面對。

再我們繼續深入這個話題之前,讓我們提醒一下自己超級智能意味著什么。

很重要的一點是速度上的超級智能和質量上的超級智能的區別。很多人提到和人類一樣聰明的超級智能的電腦,第一反應是它運算速度會非常非常快——就好像一個運算速度是人類百萬倍的機器,能夠用幾分鐘時間思考完人類幾十年才能思考完的東西

這聽起來碉堡了,而且超人工智能確實會比人類思考的快很多,但是真正的差別其實是在智能的質量而不是速度上。用人類來做比喻,人類之所以比猩猩智能很多,真正的差別并不是思考的速度,而是人類的大腦有一些獨特而復雜的認知模塊,這些模塊讓我們能夠進行復雜的語言呈現、長期規劃、或者抽象思考等等,而猩猩的腦子是做不來這些的。就算你把猩猩的腦子加速幾千倍,它還是沒有辦法在人類的層次思考的,它依然不知道怎樣用特定的工具來搭建精巧的模型——人類的很多認知能力是猩猩永遠比不上的,你給猩猩再多的時間也不行。

而且人和猩猩的智能差別不只是猩猩做不了我們能做的事情,而是猩猩的大腦根本不能理解這些事情的存在——猩猩可以理解人類是什么,也可以理解摩天大樓是什 么,但是它不會理解摩天大樓是被人類造出來的,對于猩猩來說,摩天大樓那么巨大的東西肯定是天然的,句號。對于猩猩來說,它們不但自己造不出摩天大樓,它 們甚至沒法理解摩天大樓這東西能被任何東西造出來。而這一切差別,其實只是智能的質量中很小的差別造成的。

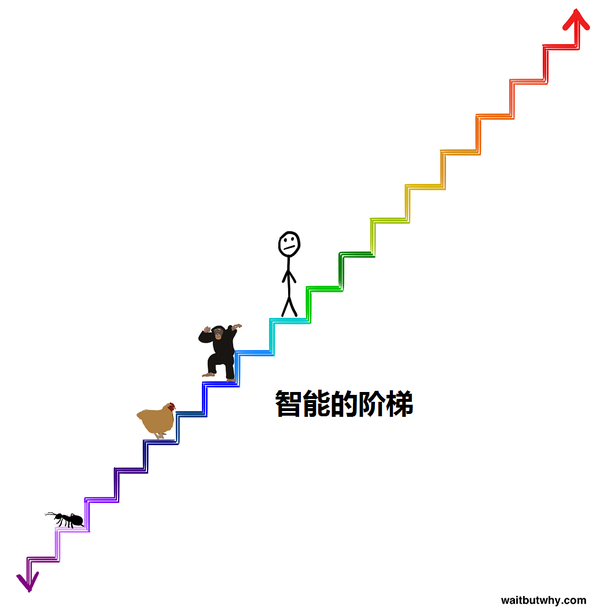

而當我們在討論超人工智能時候,智能的范圍是很廣的,和這個范圍比起來,人類和猩猩的智能差別是細微的。如果生物的認知能力是一個樓梯的話,不同生物在樓梯上的位置大概是這樣的:

要理解一個具有超級智能的機器有多牛逼,讓我們假設一個在上圖的樓梯上站在深綠色臺階上的一個機器,它站的位置只比人類高兩層,就好像人類比猩猩只高兩層 一樣。這個機器只是稍微有點超級智能而已,但是它的認知能力之于人類,就好像人類的認知能力之于猩猩一樣。就好像猩猩沒有辦法理解摩天大樓是能被造出來的 一樣,人類完全沒有辦法理解比人類高兩層臺階的機器能做的事情。就算這個機器試圖向我們解釋,效果也會像教猩猩造摩天大樓一般。

而這,只是比我們高了兩層臺階的智能罷了,站在這個樓梯頂層的智能之于人類,就好像人類之于螞蟻一般——它就算花再多時間教人類一些最簡單的東西,我們依然是學不會的。

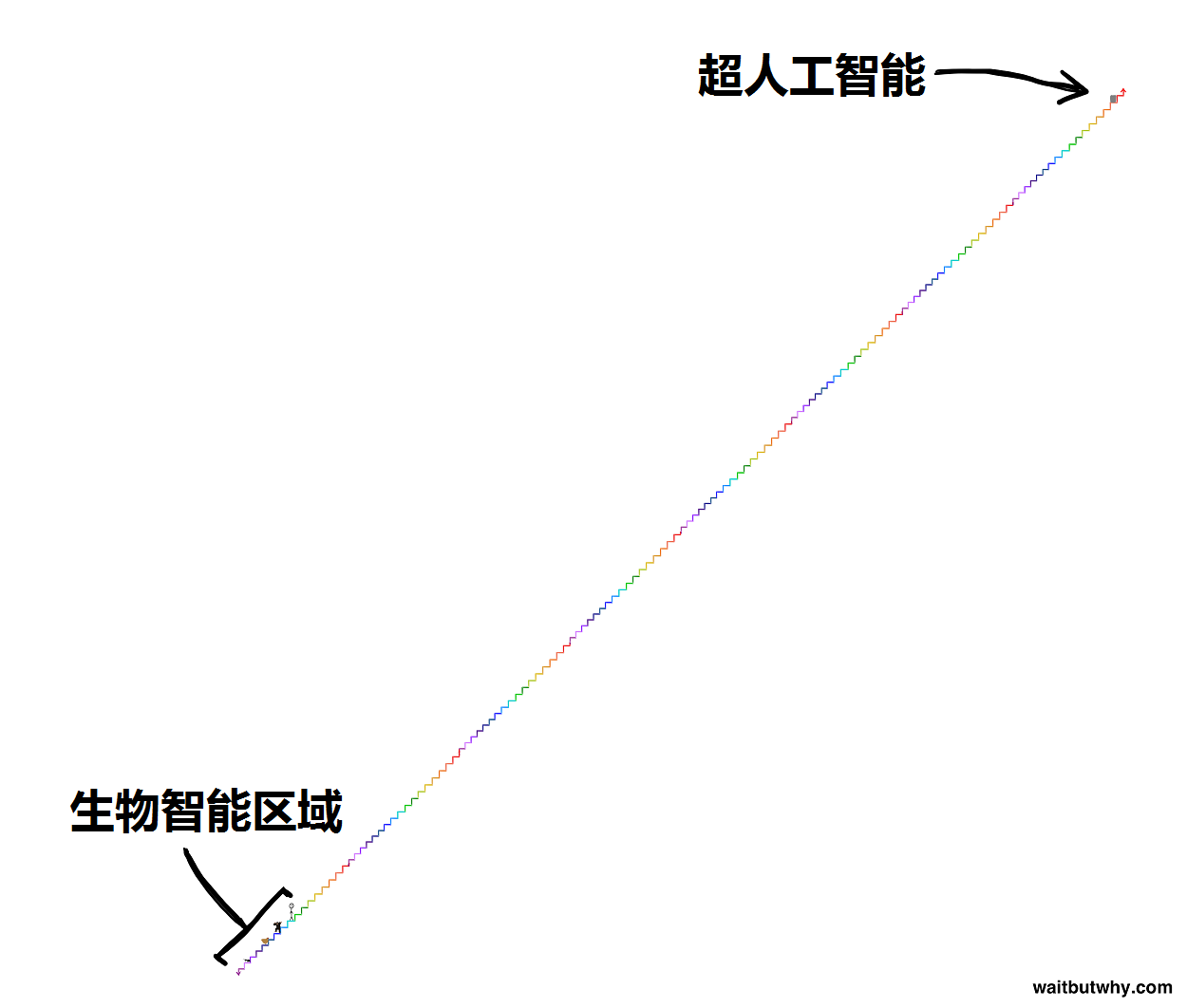

但是我們討論的超級智能并不是站在這個樓梯頂層,而是站在遠遠高于這個樓梯的地方。當智能爆炸發生時,它可能要花幾年時間才能從猩猩那一層往上邁一步,但 是這個步子會越邁越快,到后來可能幾個小時就能邁一層,而當它超過人類十層臺階的時候,它可能開始跳著爬樓梯了——一秒鐘爬四層臺階也未嘗不可。所以讓我 們記住,當第一個到達人類智能水平的強人工智能出現后,我們將在很短的時間內面對一個站在下圖這樣很高很高的樓梯上的智能(甚至比這更高百萬倍):

前面已經說了,試圖去理解比我們高兩層臺階的機器就已經是徒勞的,所以讓我們很肯定的說,我們是沒有辦法知道超人工智能會做什么,也沒有辦法知道這些事情的后果。任何假裝知道的人都沒搞明白超級智能是怎么回事。

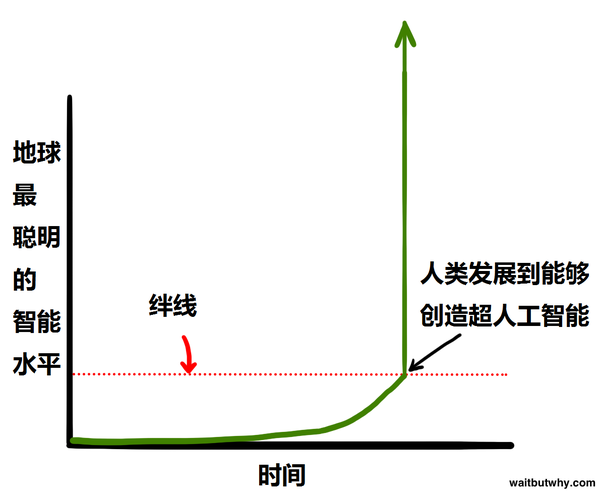

自然演化花了幾億年時間發展了生物大腦,按這種說法的話,一旦人類創造出一個超人工智能,我們就是在碾壓自然演化了。當然,可能這也是自然演化的一部分 ——可能演化真正的模式就是創造出各種各樣的智能,直到有一天有一個智能能夠創造出超級智能,而這個節點就好像踩上了地雷的絆線一樣,會造成全球范圍的大 爆炸,從而改變所有生物的命運。

前面已經說了,試圖去理解比我們高兩層臺階的機器就已經是徒勞的,所以讓我們很肯定的說,我們是沒有辦法知道超人工智能會做什么,也沒有辦法知道這些事情的后果。任何假裝知道的人都沒搞明白超級智能是怎么回事。

自然演化花了幾億年時間發展了生物大腦,按這種說法的話,一旦人類創造出一個超人工智能,我們就是在碾壓自然演化了。當然,可能這也是自然演化的一部分 ——可能演化真正的模式就是創造出各種各樣的智能,直到有一天有一個智能能夠創造出超級智能,而這個節點就好像踩上了地雷的絆線一樣,會造成全球范圍的大 爆炸,從而改變所有生物的命運。

科學界中大部分人認為踩上絆線不是會不會的問題,而是時間早晚的問題。想想真嚇人。

那我們該怎么辦呢?

可惜,沒有人都告訴你踩到絆線后會發生什么。但是人工智能思想家Nick Bostrom認為我們會面臨兩類可能的結果——永生和滅絕。

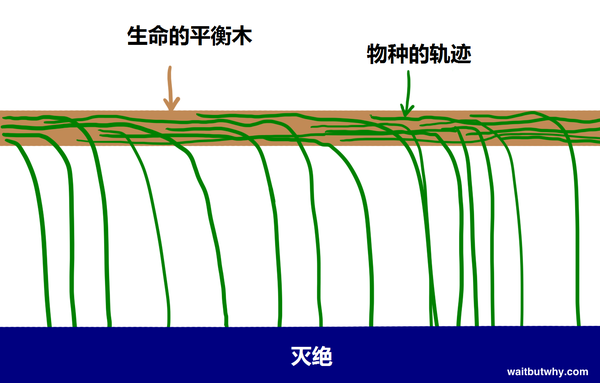

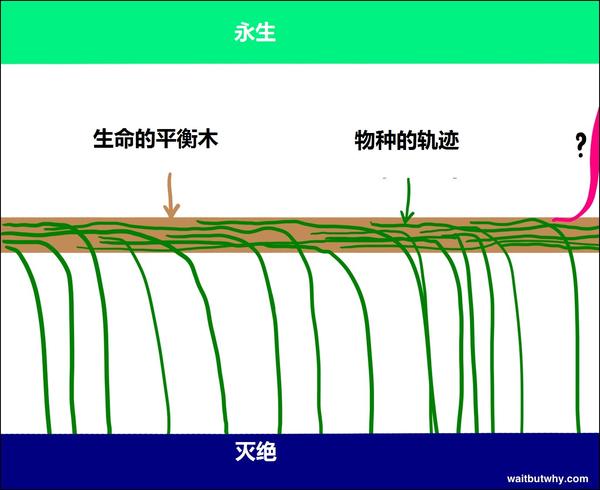

首先,回顧歷史,我們可以看到大部分的生命經歷了這樣的歷程:物種出現,存在了一段時間,然后不可避免的跌落下生命的平衡木,跌入滅絕的深淵。

歷史上來說,“所有生物終將滅絕”就像“所有人都會死”一樣靠譜。至今為止,存在過的生物中99.9%都已經跌落了生命的平衡木,如果一個生物繼續在平衡木上走,早晚會有一陣風把它吹下去。Bostrom把滅絕列為一種吸引態——所有生物都有墜入的風險,而一旦墜入將沒有回頭。

雖然大部分科學家都承認一個超人工智能有把人類滅絕的能力,也有一些人為如果運用得當,超人工智能可以幫助人類和其它物種,達到另一個吸引態——永生。 Bostrom認為物種的永生和滅絕一樣都是吸引態,也就是我一旦我們達成了永生,我們將永遠不再面臨滅絕的危險——我們戰勝了死亡和幾率。所以,雖然絕 大多數物種都從平衡木上摔了下去滅絕了,Bostrom認為平衡木外是有兩面的,只是至今為止地球上的生命還沒聰明到發現怎樣去到永生這另一個吸引態。

如果Bostrom等思想家的想法是對的,而且根據我的研究他們確實很可能是對的,那么我們需要接受兩個事實:

1)超人工智能的出現,將有史以來第一次,將物種的永生這個吸引態變為可能

2)超人工智能的出現,將造成非常巨大的沖擊,而且這個沖擊可能將人類吹下平衡木,并且落入其中一個吸引態

有可能,當自然演化踩到絆線的時候,它會永久的終結人類和平衡木的關系,創造一個新的世界,不管這時人類還是不是存在。

而現在的問題就是:“我們什么時候會踩到絆線?”以及“從平衡木上跌下去后我們會掉入哪個吸引態?”

沒人知道答案,但是一些聰明人已經思考了幾十年,接下來我們看看他們想出來了些什么。

___________

先來討論“我們什么時候會踩到絆線?”也就是什么時候會出現第一個超級智能。

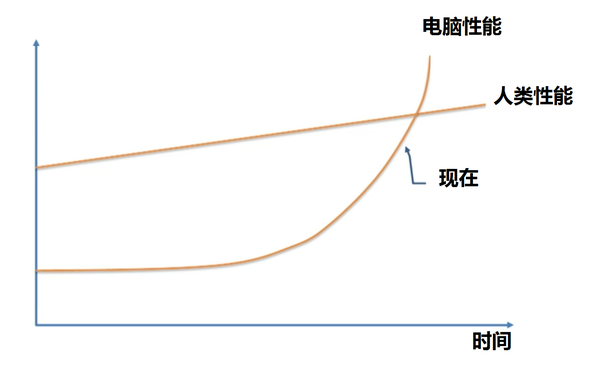

不出意外的,科學家和思想家對于這個意見的觀點分歧很大。很多人,比如Vernor Vinge教授,科學家Ben Goertzel,SUN創始人Bill Joy,發明家和未來學家Ray Kurzweil,認同機器學習專家Jeremy Howard的觀點,Howard在TED演講時用到了這張圖:

這些人相信超級智能會發生在不久的將來,因為指數級增長的關系,雖然機器學習現在還發展緩慢,但是在未來幾十年就會變得飛快。

其它的,比如微軟創始人Paul Allen,心理學家Gary Marcus,NYU的電腦科學家Ernest Davis,以及科技創業者Mitch Kapor認為Kurzweil等思想家低估了人工智能的難度,并且認為我們離絆線還挺遠的。

Kurzweil一派則認為唯一被低估的其實是指數級增長的潛力,他們把質疑他們理論的人比作那些1985年時候看到發展速度緩慢的因特網,然后覺得因特網在未來不會有什么大影響的人一樣。

而質疑者們則認為智能領域的發展需要達到的進步同樣是指數級增長的,這其實把技術發展的指數級增長抵消了。

爭論如此反復。

第三個陣營,包括Nick Bostrom在內,認為其它兩派都沒有理由對踩絆線的時間那么有信心,他們同時認為 a) 這事情完全可能發生在不久的未來 b)但是這個事情沒個準,說不定會花更久

還有不屬于三個陣營的其他人,比如哲學家Hubert Dreyfus,相信三個陣營都太天真了,根本就沒有什么絆線。超人工智能是不會被實現的。

當你把所有人的觀點全部融合起來的話是怎樣呢?

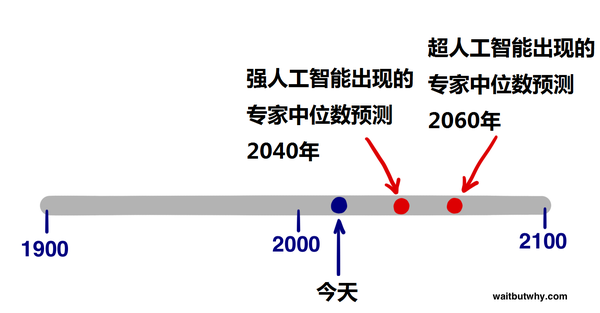

2013年的時候,Bostrom做了個問卷調查,涵蓋了數百位人工智能專家,問卷的內容是“你預測人類級別的強人工智能什么時候會實現”,并且讓回答者 給出一個樂觀估計(強人工智能有10%的可能在這一年達成),正常估計(有50%的可能達成),和悲觀估計(有90%可能達成)。當把大家的回答統計后, 得出了下面的結果:

樂觀估計中位年(強人工智能有10%的可能在這一年達成):2022年

正常估計中位年(強人工智能有50%的可能在這一年達成):2040年

悲觀估計中位年(強人工智能有90%的可能在這一年達成):2075年

所以一個中位的人工智能專家認為25年后的2040年我們能達成強人工智能,而2075年這個悲觀估計表明,如果你現在夠年輕,有一半以上的人工智能專家認為在你的有生之年能夠有90%的可能見到強人工智能的實現。

另外一個獨立的調查,由作家James Barrat在Ben Goertzel的強人工智能年會上進行,他直接問了參與者認為強人工智能哪一年會實現,選項有2030年,2050年,2100年,和永遠不會實現。結果是:

2030年:42%的回答者認為強人工智能會實現

2050年:25%的回答者

2100年:20%

2100年以后:10%

永遠不會實現:2%

這個結果和Bostrom的結果很相似。在Barrat的問卷中,有超過三分之二的參與者認為強人工智能會在2050年實現,有近乎半數(42%)的人認為未來15年(2030年)就能實現。并且,只有2%的參與者認為強人工智能永遠不會實現。

但是強人工智能并不是絆線,超人工智能才是。那么專家們對超人工智能是怎么想的呢?

Bostrom的問卷還詢問專家們認為達到超人工智能要多久,選項有a)達成強人工智能兩年內,b)達成強人工智能30年內。問卷結果如下:

中位答案認為強人工智能到超人工智能只花2年時間的可能性只有10%左右,但是30年之內達成的可能性高達75%

從以上答案,我們可以估計一個中位的專家認為強人工智能到超人工智能可能要花20年左右。所以,我們可以得出,現在全世界的人工智能專家中,一個中位的估計是我們會在2040年達成強人工智能,并在20年后的2060年達成超人工智能——也就是踩上了絆線。

當然,以上所有的數據都是推測,它只代表了現在人工智能領域的專家的中位意見,但是它告訴我們的是,很大一部分對這個領域很了解的人認為2060年是一個實現超人工智能的合理預測——距今只有45年。

那么我們來看一下下一個問題,踩到絆線后,我們將跌向平衡木的哪一個方向?

超級智能會產生巨大的力量,所以關鍵的問題時——到時這股力量究竟由誰掌握,掌握這份力量的人會怎么做?

這個問題的答案將決定超人工智能究竟是天堂還是地獄。

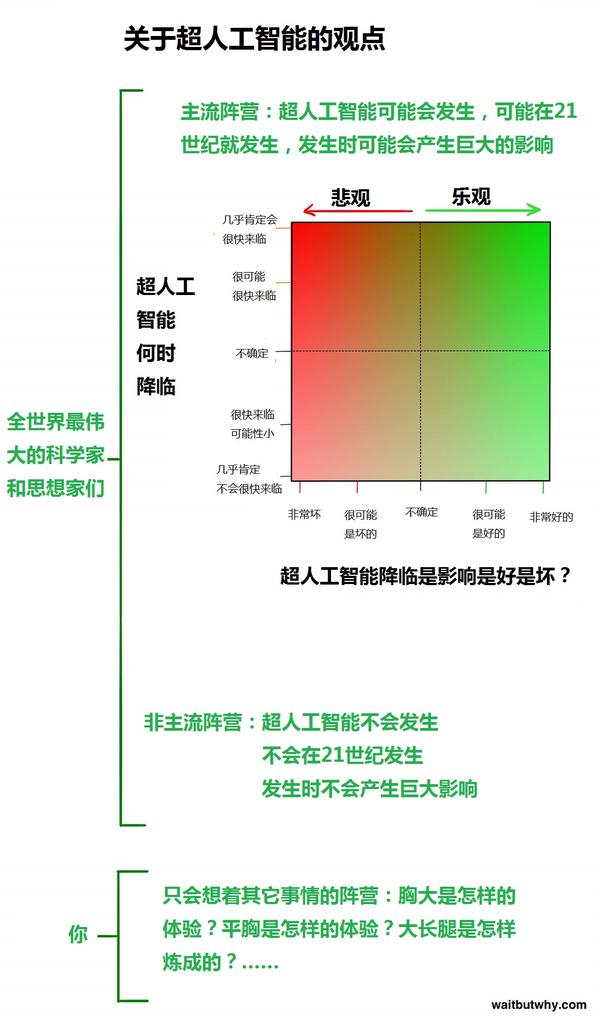

同樣的,專家們在這個問題上的觀點也不統一。Bostrom的問卷顯示專家們看待強人工智能對于人類社會的影響時,52%認為結果會是好或者非常好 的,31%認為會是糟糕的或者非常糟糕的,只有17%的人認為結果會是不好不壞的。也就是說,這個領域的專家普遍認為這將是一個很大的事情,不論結果好 壞。要注意的是,這個問題問的是強人工智能,如果問的是超人工智能,認為結果不好不壞的人可能不會有17%這么多。

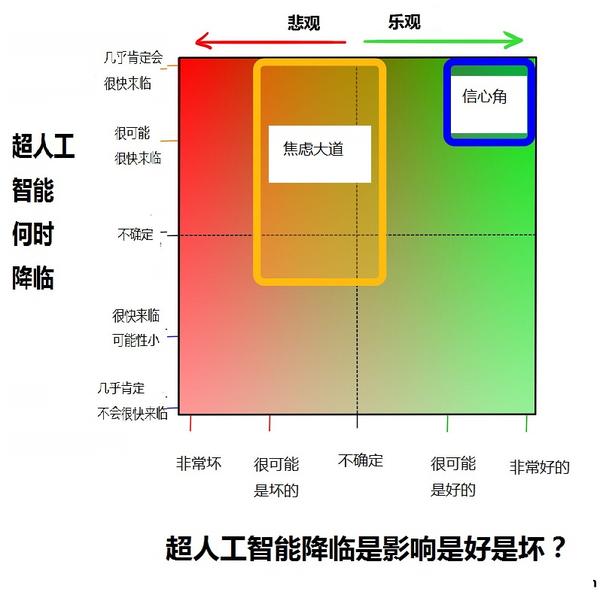

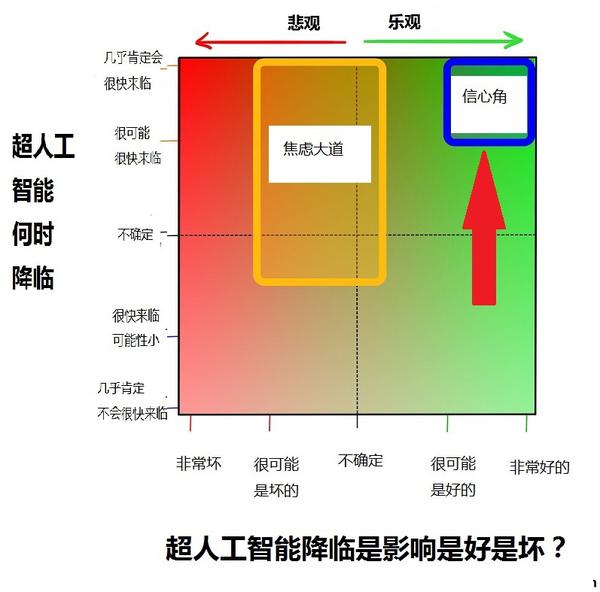

在我們深入討論好壞這個問題之前,我們先把“什么時候會發生”和“這是好事還是壞事”的結果綜合起來畫張表,這代表了大部分專家的觀點:

我們等下再考慮主流陣營的觀點。咱們先來問一下你自己是怎么想的,其實我大概能猜到你是怎么想的,因為我開始研究這個問題前也是這樣的想的。很多人其實不關心這個話題,原因無非是:

像本文第一部分所說,電影展示了很多不真實的人工智能場景,讓我們認為人工智能不是正經的課題。作家James Barrat把這比作傳染病控制中心發布吸血鬼警報一樣滑稽。

因為認知偏差,所以我們在見到證據前很難相信一件事情是真的。我確信1988年的時候電腦科學家們就已經常在討論因特網將是多么重要,但是一般人并不會認 為因特網會改變他們的生活——直到他們的生活真的被改變了。一方面,1988年的電腦確實不夠給力,所以那時的人們看著電腦會想:“這破玩意兒也能改變我 的生活,你逗我吧?”人們的想象力被自己對于電腦的體驗而約束。讓他們難以想象電腦會變成現在的樣子。同樣的事情正發生在人工智能領域。我們聽到很多人說 人工智能將會造成很大影響,但是因為這個事情還沒發生,因為我們和一些弱爆了的人工智能系統的個人經歷,讓我們難以相信這東西真的能改變我們的生活。而這 些認知偏差,正是專家們在努力對抗的。

就算我們相信人工智能的巨大潛力,你今天又花了多少時間思考“在接下來的永恒中,絕大部分時間我都不會再存在”這個問題?雖然這個問題比你今天干的大部分 事情都重要很多,但是正常人都不會老是想這個吧。這是因為你的大腦總是關注日常的小事,不管長期來看有多少重要的事情,我們天生就是這么思考的。

這篇東西的主要目標就是讓你脫離普通人陣營,加入專家思考的陣營,哪怕能讓你站到兩條不確定線的交點上,目標也達到了。

在我的研究中,我見識到了各種各樣的觀點,但是我發現大多數人的觀點都停留在主流陣營中。事實上超過四分之三的專家都屬于主流陣營中的兩個小陣營:焦慮大道和信心角

我們將對這兩個小陣營做深入的談論,讓我們從比較有趣的那個開始吧

為什么未來會是天堂

研究人工智能這個領域后,我發現有比預期的多得多的人站在信心角當中:

站在信心角中的人非常興奮,他們認為他們將走向平衡木下比較有趣的那個吸引態,未來將實現他們的夢想,他們只需耐心等待。

把這一部分人從其他思想家區分開來的是這些人對于比較有趣的那個吸引態的欲望——他們很有信心永生是我們的發展方向。

這份信心是哪里來的不好說,評論家認為是這些人太過興奮而產生了盲點,忽略了可能的負面結果。但是信心角的人還是把批評者當作末日論者來看待,他們認為技術會繼續幫助我們而不是傷害我們。

兩邊的觀點我們都會說,這樣你能形成自己的觀點,但是在讀下面的內容前,請把質疑暫時擱置,讓我們看看平衡木兩邊究竟有什么,并且記住這些事情是有可能發 生的。如果我們給一個打獵采集者看我們現在的舒適家居、技術、富庶,在他眼里這一切也會像魔法一樣——我們也要接受未來完全可能出現能把我們嚇尿的變革。

Bostrom描述了三種超人工智能可能的工作模式

-

先知模式:能準確回答幾乎所有的問題,包括對人類來說很困難的復雜問題,比如“怎樣造一個更好的汽車引擎?” -

精靈模式:能夠執行任何高級指令,比如用分子組合器造一個更好的汽車引擎出來 - 獨立意志模式(sovereign):可以執行開放式的任務,能在世界里自由活動,可以自己做決定,比如發明一種比汽車更快、更便宜、更安全的交通模式。

這些對人類來說很復雜的問題,對于一個超級智能來說可能就像“我的筆掉了,你能幫我撿一下嗎?”這么簡單。

Eliezer Yudkowsky,是這么說的:

“根本沒有困難的問題,只有對于特定級別的智能來說難的問題。在智能的階梯上走一小步,一些不可能的問題就變得簡單了,如果走一大步,所有問題都變得簡單了。”

信心角里有很多熱忱的科學家、發明家和創業者,但是對于人工智能的未來最有發言權的,當屬Ray Kurzweil.

對于Kurzweil的評價非常兩極化,既有如對神人般的崇拜,也有翻白眼似的不屑。也有一些中立主義者,比如作家Douglas Hofstadter,他覺得Kurzweil的觀點就好像把美食和狗屎混在一起,讓你分不清是好是壞。

不管你同不同意Kurzweil的觀點,他都是一個牛人。他年輕時候就開始搞發明,之后幾十年發明了很多東西,比如第一臺平板掃描儀,第一臺能把文字轉化 為語言的掃描儀(盲人使用),著名的Kurzweil音樂合成器(第一臺真正意義上的電子鋼琴),以及第一套商業銷售的語音識別系統。他是五本暢銷書的作 者。他很喜歡做大膽的預測,而且一直很準,比如他80年代末的時候預測到2000年后因特網會成為全球級的現象。他被《華爾街日報》成為“不休的天才”, 被《福布斯》稱為“終極思想機器”,被《Inc.》稱作“愛迪生真正的傳人”,被比爾蓋茨稱為“我認識的對人工智能預測最厲害的人。”2012年谷歌創始 人Larry Page曾邀請他擔任谷歌的工程總監,2011年他共同創立了奇點大學(Singularity University),現在大學由美國太空總署運運營,由谷歌贊助。

Kurzweil的經歷很重要,因為當他講述自己對未來的愿景時,他聽起來就是個瘋子,但是他不瘋,恰恰相反,他非常聰明而有知識。你可能覺得他對于未來 的想法是錯的,但是他不傻。知道他是一個聰明人讓我很開心,因為當我知道他對未來的預測后,我急切的很希望他的預測是對的。信心角中的很多思想家都認同 Kurzweil的預測,他也有很多粉絲,被稱為奇點主義者。

時間線

Kurzweil相信電腦會在2029年達成強人工智能,而到了2045年,我們不但會有超人工智能,還會有一個完全不同的世界——奇點時代。他的人工智能時間線曾經被認為非常的狂熱,現在也還是有很多人這么認為,但是過去15年弱人工智能的快速發展讓更多的專家靠近了Kurzweil的時間線。雖然他的時間線比之前提到的2040年和2060年更加早,但是并沒有早多少。

Kurzweil的奇點時代是三個技術領域的共同革命造成的——生物技術、納米技術和最重要的人工智能技術。

在我們繼續討論人工智能前,讓我們談一下納米技術這個任何關于人工智能的討論都會涉及到的領域

納米技術

納米技術說的是在1-100納米的范圍內操縱物質的技術。一納米是一米的十億分之一,是一毫米的一百萬分之一。1-100納米這個范圍涵蓋了病毒(100納米長),DNA(10納米寬), 大分子比如血紅蛋白(5納米),和中分子比如葡萄糖(1納米)。當我們能夠完全掌握納米技術的時候,我們離在原子層面操縱物質就只差一步了,因為那只是一個數量級的差距(約0.1納米)。

要了解在納米量級操縱物質有多困難,我們可以換個角度來比較。國際空間站距離地面431公里。如果一個人身高431公里,也就是他站著能夠頂到國際空間站的話,他將是普通人類的25萬倍大。如果你把1-100納米放大25萬倍,你算出的是0.25毫米-25毫米。所以人類使用納米技術,就相當于一個身高431公里的巨人用沙子那么大的零件搭精巧的模型。如果要達到原子級別操縱物質,就相當于讓這個431公里高的巨人使用0.025毫米大的零件